技术介绍

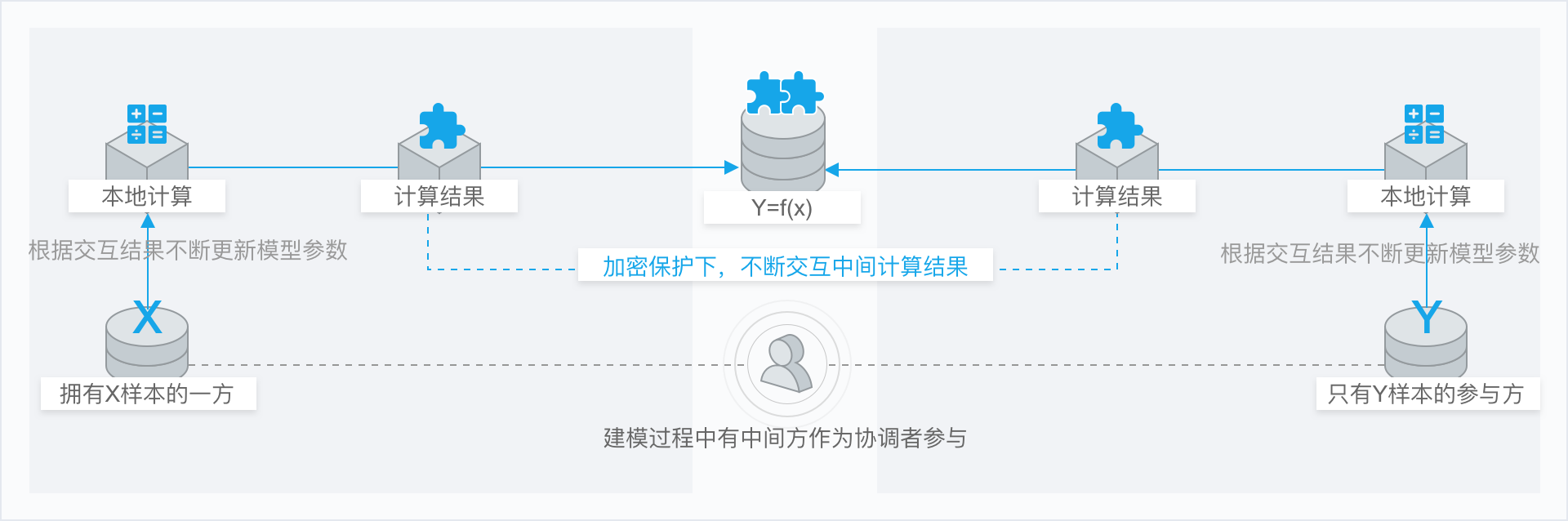

原始数据不出门,参与各方本地建模,没有敏感数据流通,交互加中间值。参与方只有自己模型参数,整个模型被保护,支持分散机器学习。

机器学习算法全部重构重写,数据不动算法跑上门。支持逻辑回归、随机森林、xgBoost、lightGBM、神经网络等,样本对齐,加密状态安全求交集形成虚拟融合样本集。分散在各方本地加密计算中间结果,各方中间结果协同加密交互计算,多轮迭代收敛产生训练模型。

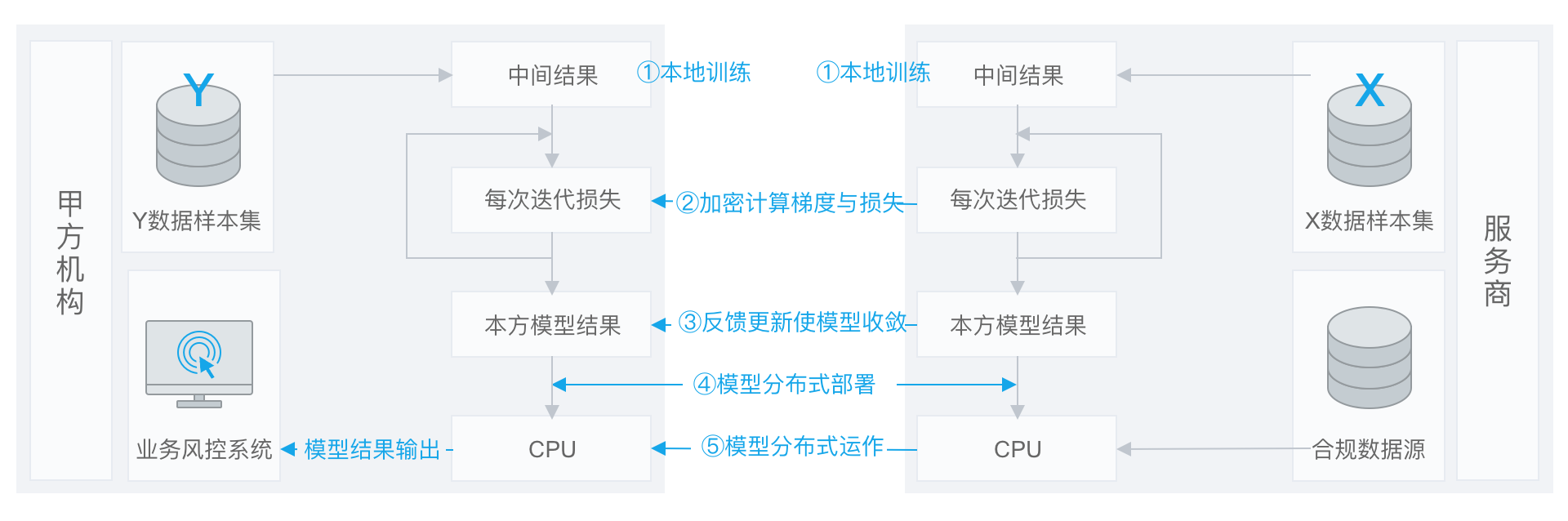

技术流程

在确定共有用户群体后,就可以利用这些数据训练机器学习模型。以线性回归模型为例,训练过程可分为以下 5 步:

第①步:A和B把各自公钥分发给对方,用以对训练过程中需要交换的数据进行加密;

第②步:A和B分别进行本地的训练,产生不含敏感信息的中间结果。

第③步:A和B之间以加密形式交互用于计算梯度的中间结果;

第④步:A和B分别基于加密的梯度值进行计算,同时 B 根据其标签数据计算损失,并汇总计算总梯度;

第⑤步:A和B根据新计算的梯度更新各自模型的参数。

迭代上述步骤直至损失函数收敛,这样就完成了整个训练过程。在样本对齐及模型训练过程中,A和B各自的数据均保留在本地,且训练中的数据交互也不会导致数据隐私泄露。因此,双方在联邦学习的帮助下得以实现合作训练模型。

版权所有:上海富数科技有限公司 | 沪ICP备16021730号-1 | 沪公安备案号31011502009164号